难道你也要因为数据同步失误,错失上亿销售额吗?

作者:佚名 时间:2025-11-13 08:37

身为一名长时间留意数据技术演变的小编,我察觉到数据同步这一貌似基础的技术环节,正演变成越来越多企业数字化转型里的关键痛点。特别是在电商、金融等对实时性有着高要求的领域,数据同步的可靠性以及时效性都与业务决策的准确度发生着直接关联。

全量同步的局限

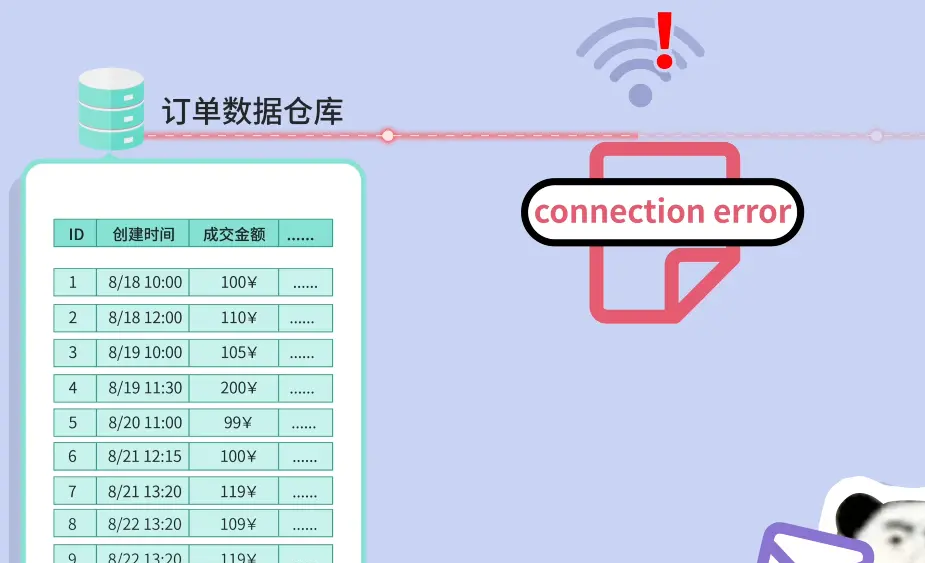

近期,某电商平台技术团队披露,他们曾采用一种方案,此方案是每日全量同步订单数据,该方案要求,每晚凌晨的时候,要把超过500GB规模的订单表完整地复制到数据分析仓库,整个复制过程持续大概3小时,技术负责人表明,这种方式较简单且显得粗暴,在数据量较小的情况下还能够被接受,然而随着业务不断增长,全表同步所需要的时间已经快要接近维护窗口的极限了。

更糟糕的情形是,去年双十一那段时期,因网络出现波动致使同步发生中断,到了次日运营团队所看到的依旧是前一日的数据。这样的失误直接致使热销商品的补货出现延迟,经估算造成当日的销售额损失大概为15%。此事件推动团队着手去寻找更为高效的数据同步方案。

# 查出全部订单

orders = db.query("SELECT * FROM orders")

# 清空已有老数据

warehouse.execute("DELETE FROM orders")

# 插入新值

warehouse.insert(order)

增量同步的优势

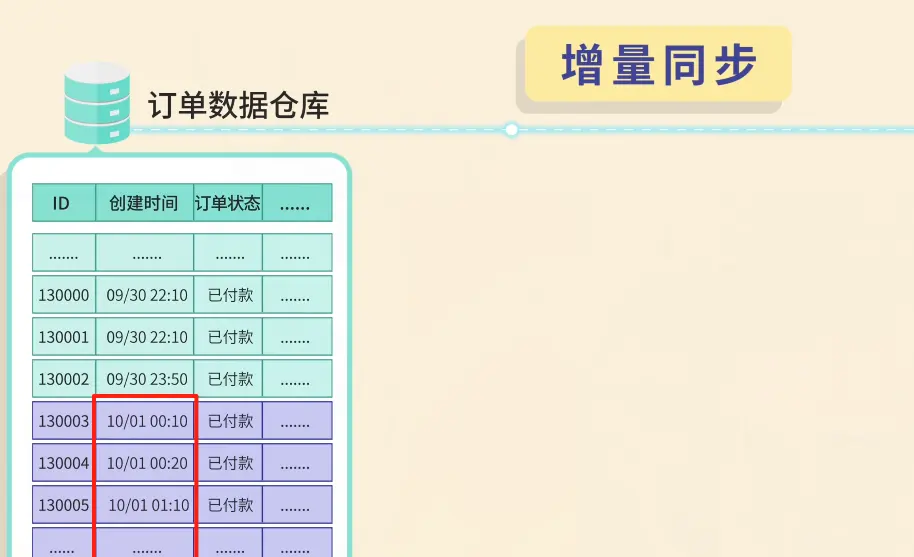

随后,团队实施了基于时间戳的增量同步机制,新方案只同步每日新增以及变更的订单记录,数据量降低到全量同步的8%,同步时间从3小时压缩到20分钟之内,并且支持每日多个同步时段,这一改进让数据分析团队能够获取最新订单状态,为库存管理提供更及时的依据 。

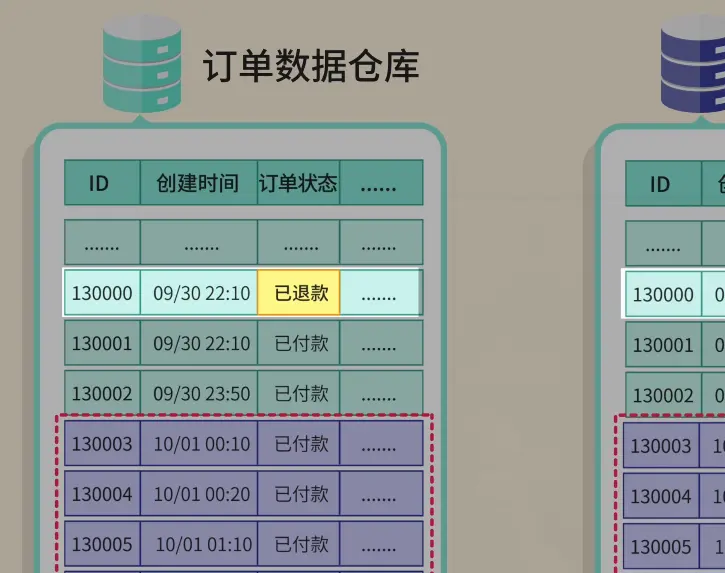

可是,技术人员没多久就察觉到了新状况。仅仅依靠订单生成时间当作同步的依据,没办法获取订单状态之后的更新。比如说客户更改收货地址或者取消订单这类行为,这些变动没办法借助原有的机制同步到数据仓库,导致了数据不一致 。

数据分页的陷阱

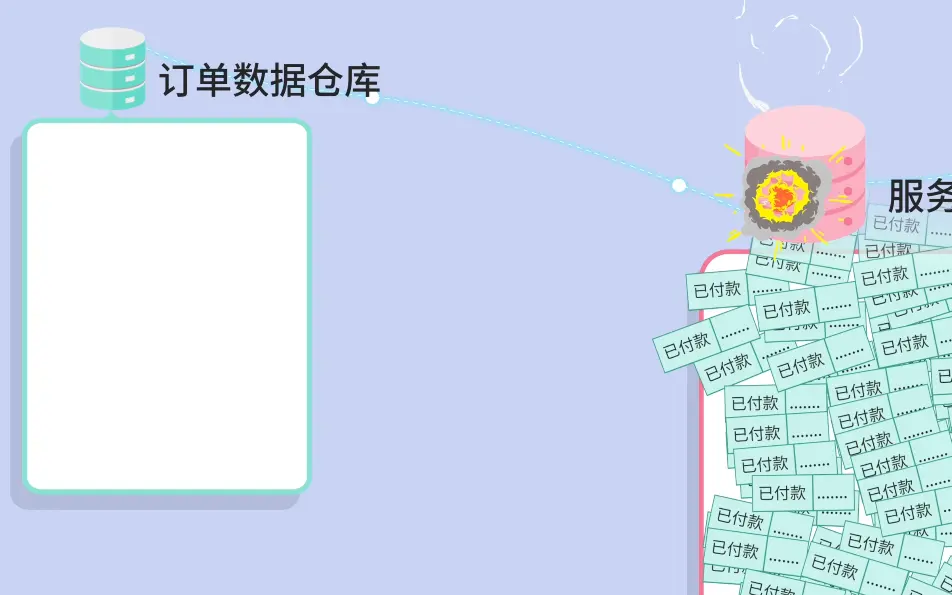

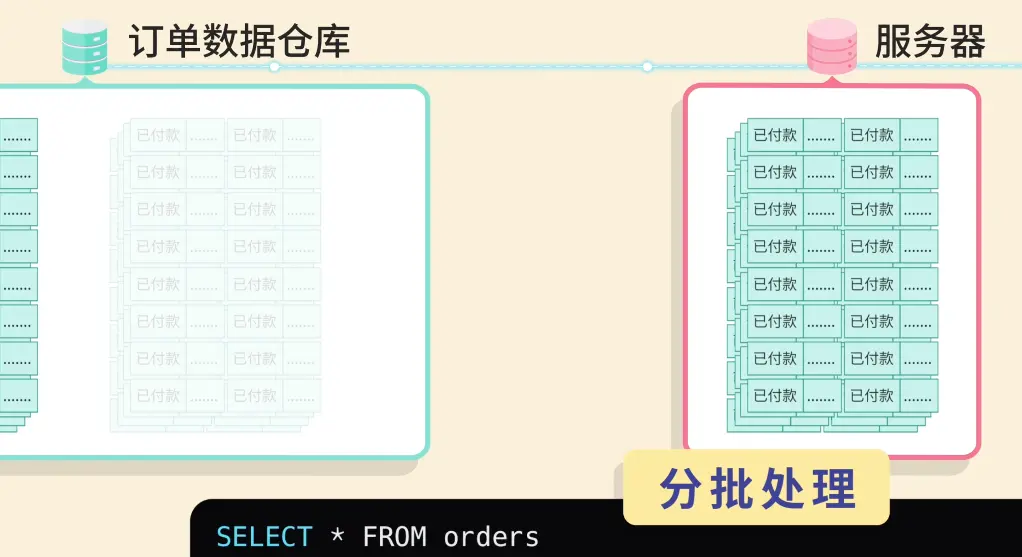

为了去解决处在大数据量这种情形下同步所存在的稳定性这类的问题,我们这个团队最开始的时候采用了分页查询这样一种策略,是按照每一页1000条记录的方式去进行分批次处理的。然而呢,在实际进行测试的过程当中,技术人员发现了这样一种情况,就是当同步操作进行到中间部分的时候,新产生出来的订单记录会致使分页偏移量的计算出现错误,进而造成一部分数据出现了重复亦或者遗漏的状况。

排查过后,问题出于数据库的动态特性,同步进程里,持续生成的订单数据改动了记录的总数与位置,致使基于固定偏移量的分页办法变得不再靠谱,该发现促使团队重新构想分页逻辑,。

游标分页的改进

接着技术团队引入了以订单 ID 作为游标标记的基于游标的分页机制,此方案能保证在同步进程当中,就算有新数据被插入,也不会对已同步记录的准确性造成影响,实行之后,数据同步的准确率达到了 100%,将分页过程里的数据丢失问题完全解决了。

游标分页存在着另外一个优势,此优势在于性能能够得到提升,相较于传统分页,在面对大数据量时会出现性能衰减的情况,游标分页在处理百万级记录这个状况下,依旧能够维持稳定的响应时间,而这一点便为频繁同步造就了技术基础。

批量操作优化

在同步频率逐步递增之际,团队着手对数据插入效率予以优化,把单条插入的方式转变为批量操作,每一回所处理的记录数目为 1000 条,最终使得数据库的写入速度在一定程度上得到了约 40 倍的提升。于此期间,经由对数据库事务进行合并处理,将网络往返过程中所产生的开销作了有效的减少,如此一来,明显把同步过程当中对于线上业务所造成的影响削减了不少。

技术团队引入了连接池,还引入了预处理语句,以此进一步优化数据库资源化利用情况。这些改进致使同步任务能够在两个小时之内完成并且得以将全部增量数据处置干净,进而满足业务部门对于数据时效性的要求 。

实时同步方案

为了达成业务对于处于实时状态的数据所抱有的需求目的,团队在最终阶段部署了一种基于CDC也就是变更数据捕获以及消息队列的实时同步方案举措。这个方案借助解析数据库日志的方式来捕获数据变更情况,经过消息队列以异步形式传输达到数据仓库部位,达成了订单数据之处在100毫秒的时间范围之内能够被看见的结果。

这一架构有着不错的扩展性以及包容错误的能耐,在数据量急剧增多之际,消息队列开展缓冲的功用,防止给源数据库施加压力,与此同时,对于消费者组进行多实例的布置,保障了系统在部分组件出现问题之时依然能够不间断运行,促成了企业层面的数据同步保障 。

订单 A:updateTime=08:00

订单 B:updateTime=09:00

订单 C:updateTime=09:30

订单 D:updateTime=09:50

身为技术方面的从业者,我打算向诸位读者进行请教:在尔等的数据同步相关实践当中呵,究竟是以怎样的方式将数据一致性跟系统性能予以平衡的呢?欢迎于评论区域把你的那些经验分享出来哟,要是觉得这篇文章具备着一定帮助的话呀,请给予点赞予以支持并且分享给更多同行业的人呢。

SELECT * FROM orders

WHERE updated_time >= '2025-09-08' and updated_time < '2025-09-09'

ORDER BY updated_time

LIMIT 2 OFFSET 0; -- 每页 2 条,第 1 页