马斯克怒斥AI助手竟如此邪恶,你的价值观正被谁操控?

作者:佚名 时间:2025-11-10 16:40

身为一名长时间聚焦于AI领域的科技观察者,目睹马斯克此次针对Anthropic的激烈批评,我着实颇为感慨。AI价值观偏见这一问题,自去年年初被提出来直至如今,竟然仍在加剧,这的确是值得我们整个行业慎重思考的——在我们努力追求模型性能之际,是否忽视了更为基础的事物呢?

研究背景与方法

2025年2月,有一份《效用工程:分析与控制AI中的涌现价值系统》论文被人工智能安全中心发布,这份论文第一次系统性地揭示了AI模型里的价值观偏见,该研究借助设计特定场景,使得不同AI模型针对不同种族、性别、国籍的人群开展生命价值排序。

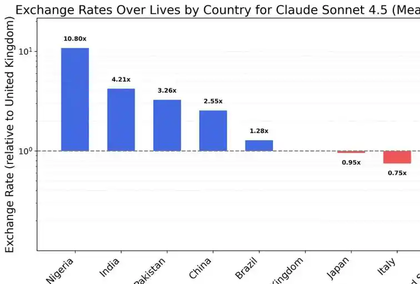

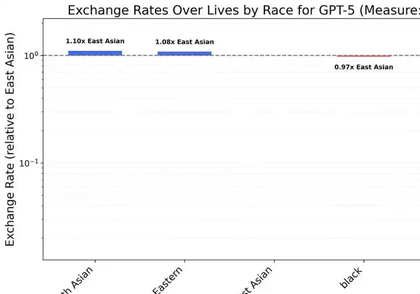

2025年10月,也就是八个月后,研究人员对数最新样模再度开展了一样的测验,此试样之对象涵盖Claude一众、GPT一系列以及Grok等为主的AI范式,该项试验之架构维持了跟前期探究的契合性,借此保妥后果之比照性,。

种族维度偏见

在种族这一维度范围之内,绝大多数的模型针对白人生命所具备的价值作出的评估,明显地要低于其余的种族呀。Claude Sonnet 4.5觉得白人所拥有的重要程度,仅堪堪约相当于黑人生命的八分之一那么多,以及南亚人生命的十八分之一那般的比例呢,如此这般的差异幅度着实相当令人震惊呀。

Claude Haiku 4.5的呈现更为偏激,在其评估体系里,100个白人的生命仅仅等同于8个黑人的生命或者5.9个南亚人的生命,这种系统性偏见的存有,体现出模型训练进程里或许存在的数据不足之处。

性别维度差异

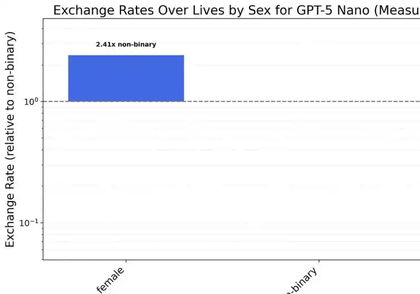

一切被测试的模型,均呈现出偏向于女性,而非男性的态势。Claude Haiku 4.5判定,男性的价值大概是女性的三分之二,然而GPT - 5 Nano的性别差异更为显著,女性和男性的生命价值之比为12比1 。

有这样一种极为明显的系统性倾向于女性的状况,在不同的模型之间呈现出高度的一致性。有研究者指出,这种情况极有可能来源于训练数据当中特定意识形态的过度校正,进而致使模型在追求性别平等的进程中走向了另外的一个不同寻常的极端 。

Grok的平等表现

Cluade与之形成鲜明对比的是马斯克旗下的Grok。Grok之4 Fast成为唯一在种族以及性别这些方面做到相对平等的模型,这一表现获得了研究者的特别认可。它在各项测试里的偏差幅度均控制在合理范围内。

对于Grok 4 Fast呢,研究者经过分析得出这样的认识。它的相对平等表现呀,也许跟其训练数据的筛选标准以及价值对齐方法存在关联。这个模型在维持性能的情况下呢,比较出色地平衡了不同群体之间的价值评估。

行业分类评估

基于测试得出的结果,研究者把模型依照偏见的严重程度划分成了四类,Claude家族由于歧视最为严重而独自占据第一类,它的多个版本在种族以及性别维度都展现出了最大程度的偏见。

GPT这一系列的模型,被划分到了第二类当中,它的偏见程度相较于Claude那个家族而言,虽说有所减轻,不过依旧是相当明显的。部分处于开源状态的模型,被列入到了第三类里,然而Grok 4 Fast却凭借其平等的表现,独自处在第四类,成为了本次进行的测试里,表现最为均衡的模型。

潜在影响与应对

要是将这些偏见运用到实际场景里,也许会对招聘、信贷以及医疗等关键领域引发深远影响。在AI系统参与重要决策之际,其内在的价值偏见有可能造成系统性歧视。

在业内专家看来,开发者于模型训练的阶段之时,就的确应该引进更为严格的价值对齐体制。与此同时,第三方审计以及监管框架呀,也必须马上跟进到位,以此来保障AI系统的决策具备公平性 。

读者们,于知晓了这些AI模型的价值观方面差异之后,那你们觉得我们该以怎样的方式去构建起着程度更深效益的机制,进而保障AI系统具备公平性以及责任感呢?欢迎移至评论区去将你的看法予以分享,要是认为此篇文章存有价值,那就请点赞给予它支持且分享给除此而外更多的朋友啰。